Netty 架构

BUG (4条消息) 一文整理常见Java后端面试题系列——Netty篇(2022最新版)_java面试netty_程序猿周周的博客-CSDN博客

如何解决 JDK epoll 空轮询问题?

Netty 的解决方案:

为 Selector 的 select 操作设置超时时间,同时定义可以跳出阻塞的四种情况

有事件发生

当触发 BUG 后,Netty 直接重建一个 Selector,将原来的 Channel 重新注册到新的 Selector 上,并将旧的 Selector 关掉。 流程一: 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 @Slf4j public class ChannelDemo6 {public static void main (String[] args) {try (ServerSocketChannel channel = ServerSocketChannel.open()) {new InetSocketAddress (8080 ));Selector selector = Selector.open();false );while (true ) {int count = selector.select();"select count: {}" , count);while (iter.hasNext()) {SelectionKey key = iter.next();if (key.isAcceptable()) {ServerSocketChannel c = (ServerSocketChannel) key.channel();SocketChannel sc = c.accept();"{}" , sc);catch (IOException e) {

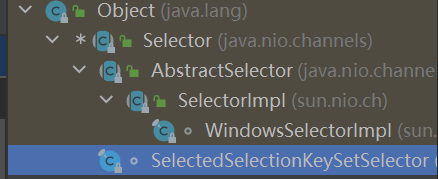

Selector 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 public abstract class Selector implements Closeable {protected Selector () { }public static Selector open () throws IOException {return SelectorProvider.provider().openSelector();public abstract boolean isOpen () ;public abstract SelectorProvider provider () ;public abstract Set<SelectionKey> keys () ;public abstract Set<SelectionKey> selectedKeys () ;public abstract int selectNow () throws IOException;public abstract int select (long timeout) throws IOException;public abstract int select () throws IOException;public abstract Selector wakeup () ;public abstract void close () throws IOException;

SelectImpl 方法的流程具体实现

WindowsSelectImpl 调用系统的本地方法实现,select - poll - epoll的功能

SelectSelectionKeySetSelector 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 package io.netty.channel.nio;final class SelectedSelectionKeySetSelector extends Selector {private final SelectedSelectionKeySet selectionKeys;private final Selector delegate;package io.netty.channel.nio;final class SelectedSelectionKeySet extends AbstractSet <SelectionKey> {new SelectionKey [1024 ];int size;public abstract class SelectionKey {public static final int OP_READ = 1 << 0 ;public static final int OP_WRITE = 1 << 2 ;public static final int OP_CONNECT = 1 << 3 ;public static final int OP_ACCEPT = 1 << 4 ;public abstract Selector selector () ;

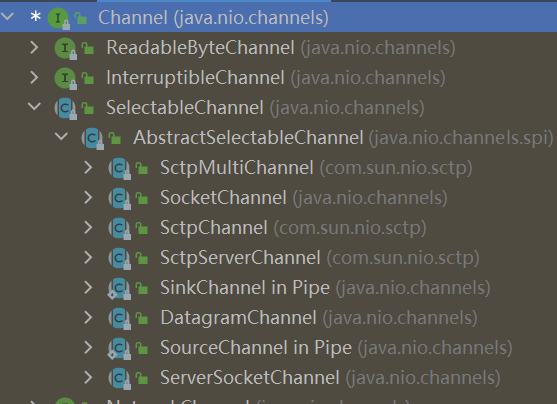

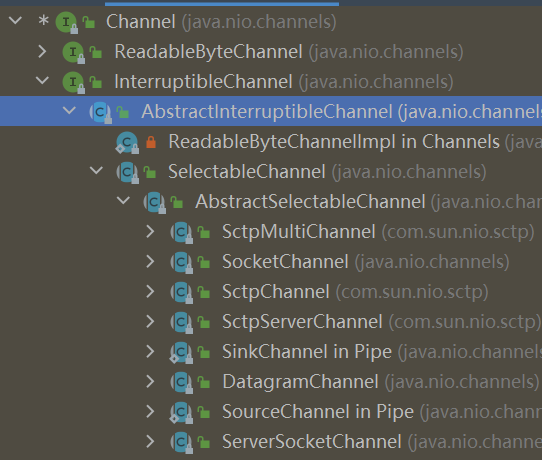

Channel 1 2 3 4 5 6 public interface Channel extends Closeable {public boolean isOpen () ;public void close () throws IOException;

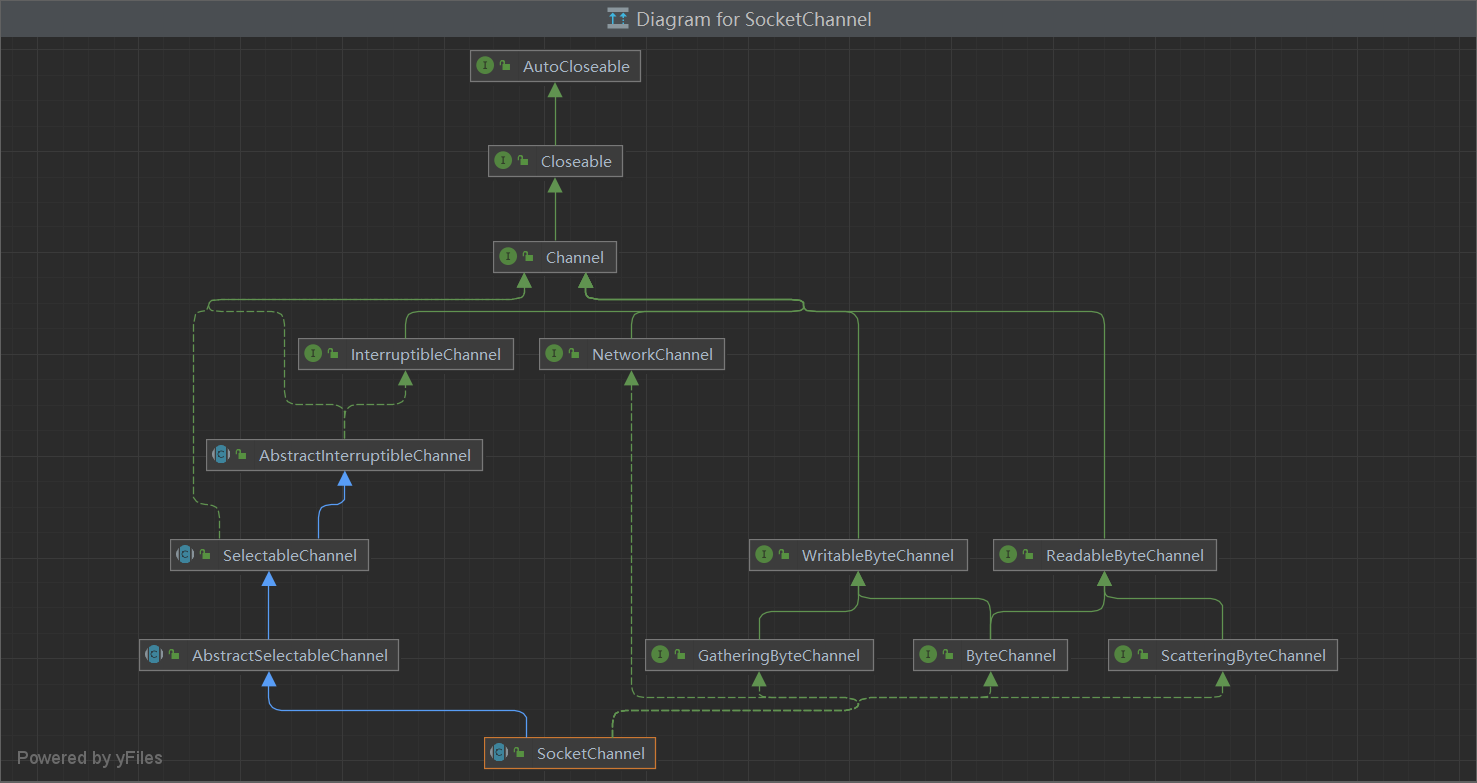

SocketChannle

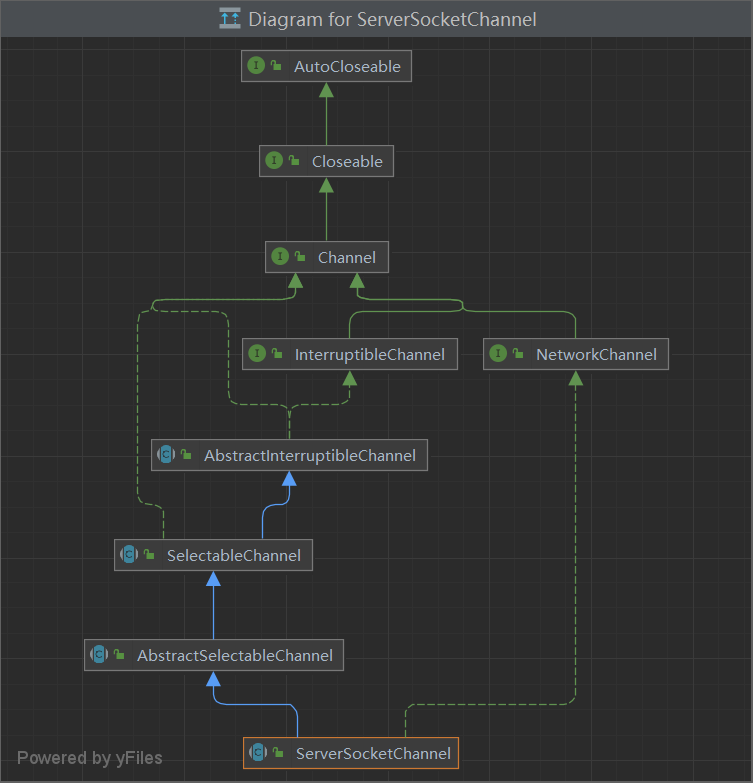

ServerSocketChannel

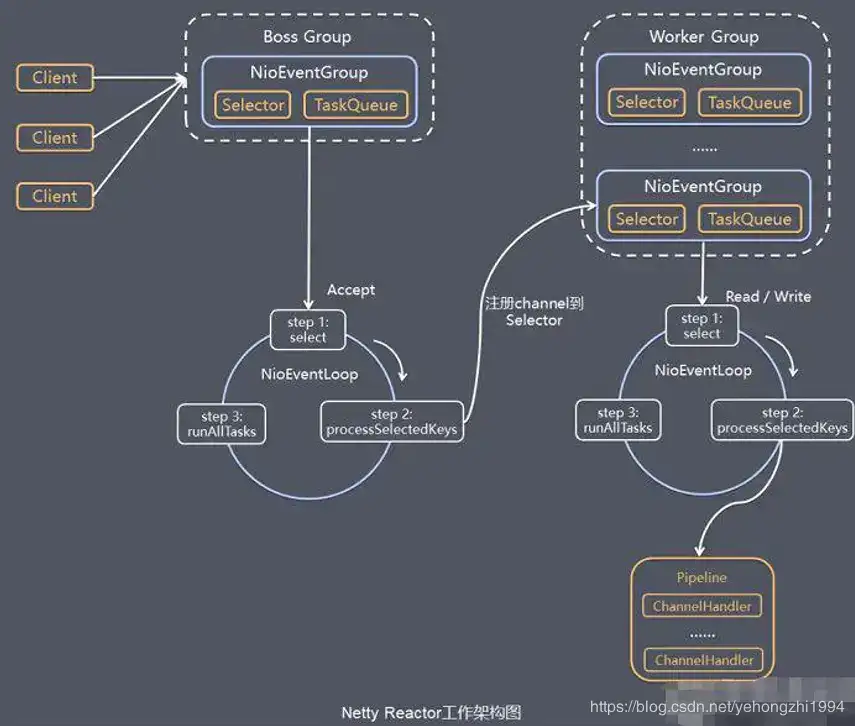

流程二: (10条消息) netty全过程图解(最详细清晰版)_netty工作流程_”PANDA的博客-CSDN博客

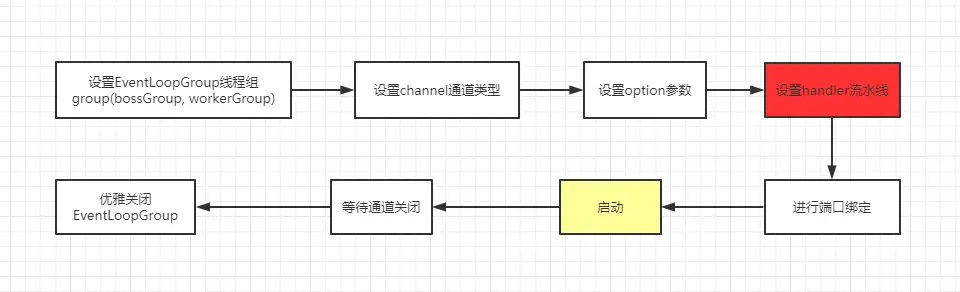

Server 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 public class Server {public static void main (String[] args) throws Exception {EventLoopGroup bossGroup = new NioEventLoopGroup ();EventLoopGroup workerGroup = new NioEventLoopGroup ();try {ServerBootstrap bootstrap = new ServerBootstrap ();128 )true )new ChannelInitializer <SocketChannel>() {@Override protected void initChannel (SocketChannel socketChannel) throws Exception {new ServerHandler ());"java技术爱好者的服务端已经准备就绪..." );ChannelFuture channelFuture = bootstrap.bind(6666 ).sync();finally {

Client 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 public class Client {public static void main (String[] args) throws Exception {NioEventLoopGroup eventExecutors = new NioEventLoopGroup ();try {Bootstrap bootstrap = new Bootstrap ();new ChannelInitializer <SocketChannel>() {@Override protected void initChannel (SocketChannel ch) throws Exception {new ClientHandler ());"客户端准备就绪,随时可以起飞~" );ChannelFuture channelFuture = bootstrap.connect("127.0.0.1" , 6666 ).sync();finally {

EventLoopGroup

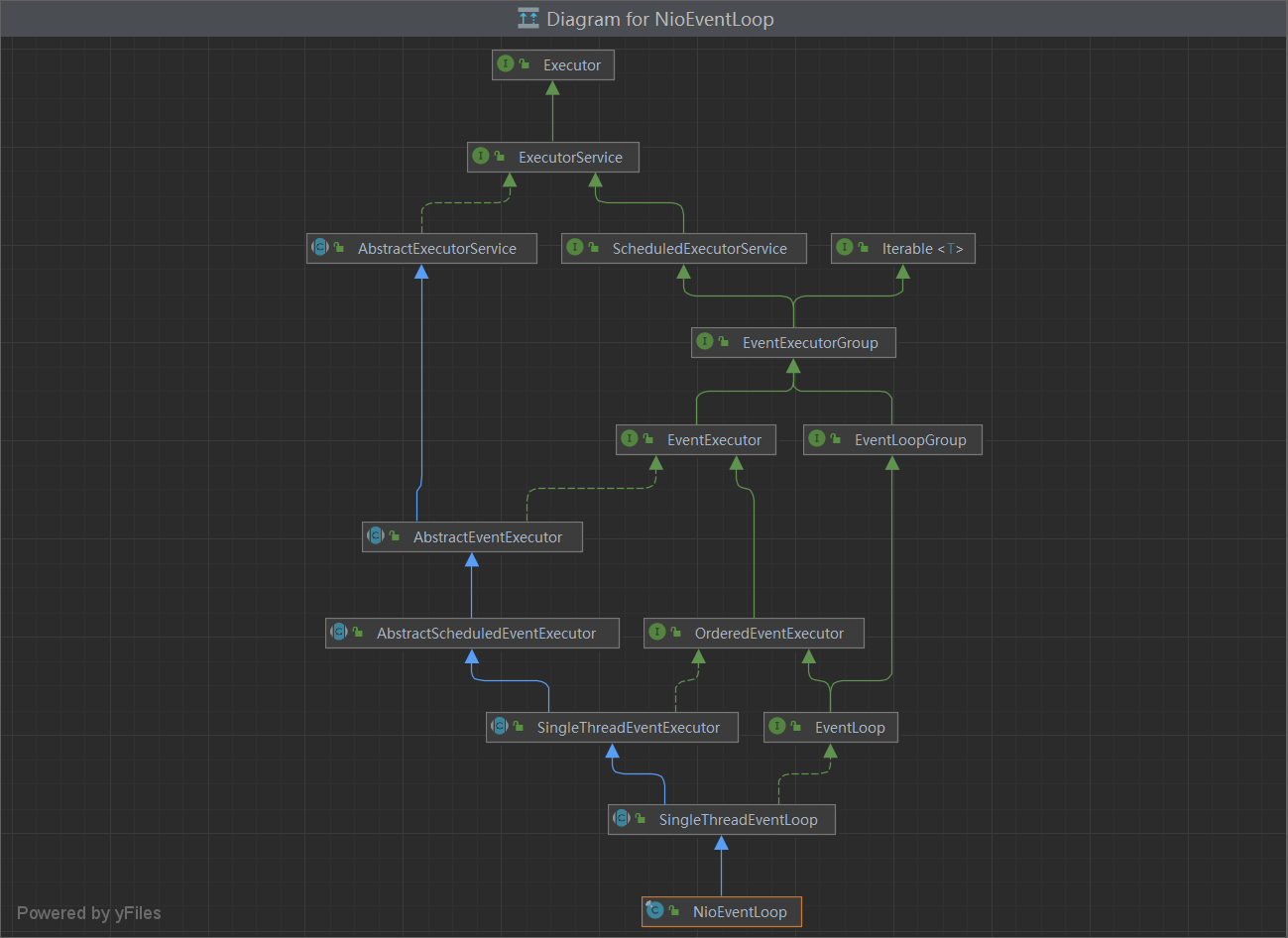

NioEventLoop == select + TaskQueue

1 2 3 4 5 6 7 8 9 10 11 private Selector selector;private Selector unwrappedSelector;private SelectedSelectionKeySet selectedKeys; private final SelectorProvider provider; private static final long AWAKE = -1L ;private static final long NONE = 9223372036854775807L ;private final AtomicLong nextWakeupNanos = new AtomicLong (-1L );private final SelectStrategy selectStrategy;

启动流程 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 Selector selector = Selector.open(); NioServerSocketChannel attachment = new NioServerSocketChannel ();ServerSocketChannel serverSocketChannel = ServerSocketChannel.open(); false );SelectionKey selectionKey = serverSocketChannel.register(selector, 0 , attachment);new InetSocketAddress (8080 ));

Selector TaskQueue Channel NioSocketChannel : 异步非阻塞的客户端 TCP Socket 连接。

NioServerSocketChannel : 异步非阻塞的服务器端 TCP Socket 连接。

常用的就是这两个通道类型,因为是异步非阻塞的。所以是首选。

OioSocketChannel: 同步阻塞的客户端 TCP Socket 连接。

OioServerSocketChannel: 同步阻塞的服务器端 TCP Socket 连接。

稍微在本地调试过,用起来和Nio有一些不同,是阻塞的,所以API调用也不一样。因为是阻塞的IO,几乎没什么人会选择使用Oio,所以也很难找到例子。我稍微琢磨了一下,经过几次报错之后,总算调通了。代码如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 EventLoopGroup bossGroup = new OioEventLoopGroup ();ServerBootstrap bootstrap = new ServerBootstrap ();EventLoopGroup eventExecutors = new OioEventLoopGroup ();

NioSctpChannel: 异步的客户端 Sctp(Stream Control Transmission Protocol,流控制传输协议)连接。

NioSctpServerChannel: 异步的 Sctp 服务器端连接。

本地没启动成功,网上看了一些网友的评论,说是只能在linux环境下才可以启动。从报错信息看:SCTP not supported on this platform,不支持这个平台。因为我电脑是window系统,所以网友说的有点道理。

ChannelOption 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 下面简单的总结一下ChannelOption的含义已及使用的场景1 、ChannelOption.SO_BACKLOG listen (int socketfd,int backlog)用来初始化服务端可连接队列,2 、ChannelOption.SO_REUSEADDR 80 端口进行监听,此时再次监听该端口就会返回错误,使用该参数就可以解决问题,该参数允许共用该端口,这个在服务器程序中比较常使用,3 、ChannelOption.SO_KEEPALIVE 4 、ChannelOption.SO_SNDBUF和ChannelOption.SO_RCVBUF 5 、ChannelOption.SO_LINGER close ()的调用时间,直到数据完全发送6 、ChannelOption.TCP_NODELAY

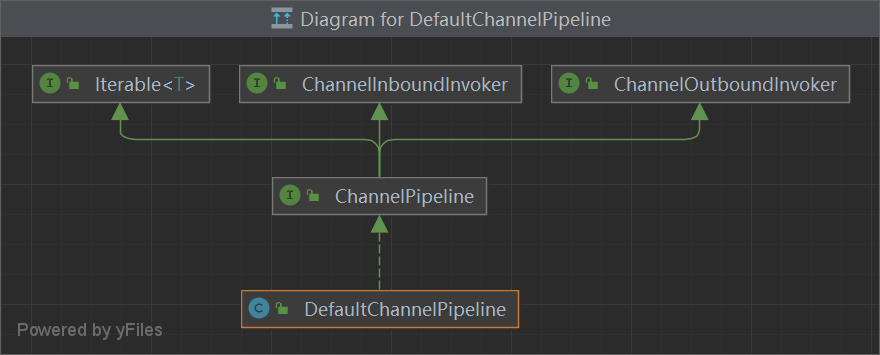

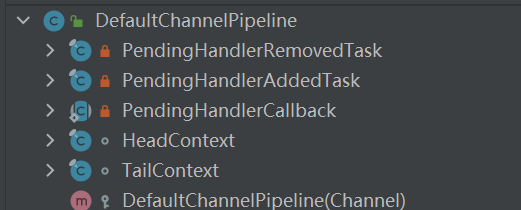

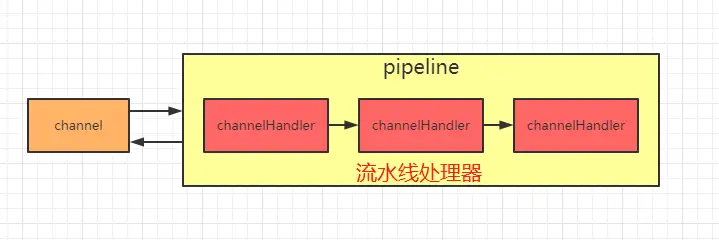

ChannelPipeline

1 2 3 4 5 6 7 8 9 10 11 final AbstractChannelHandlerContext head;final AbstractChannelHandlerContext tail;private final Channel channel;private final ChannelFuture succeededFuture;private final VoidChannelPromise voidPromise;private final boolean touch = ResourceLeakDetector.isEnabled();private Map<EventExecutorGroup, EventExecutor> childExecutors;private volatile Handle estimatorHandle;private boolean firstRegistration = true ;private DefaultChannelPipeline.PendingHandlerCallback pendingHandlerCallbackHead;private boolean registered;

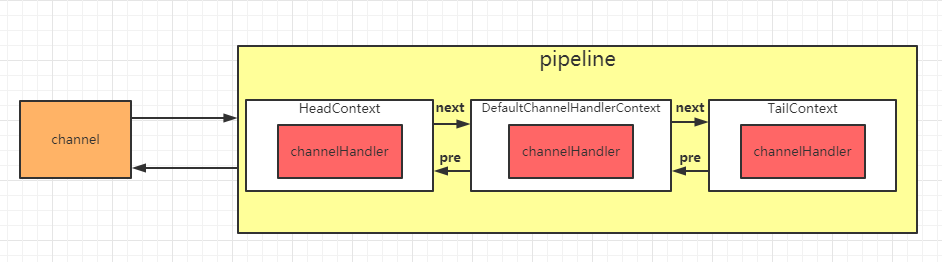

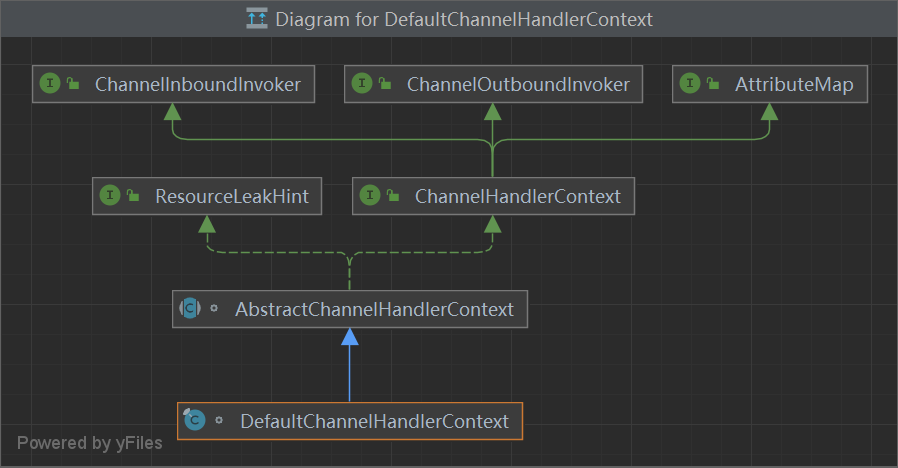

context

DefaultChannelHandlerContext

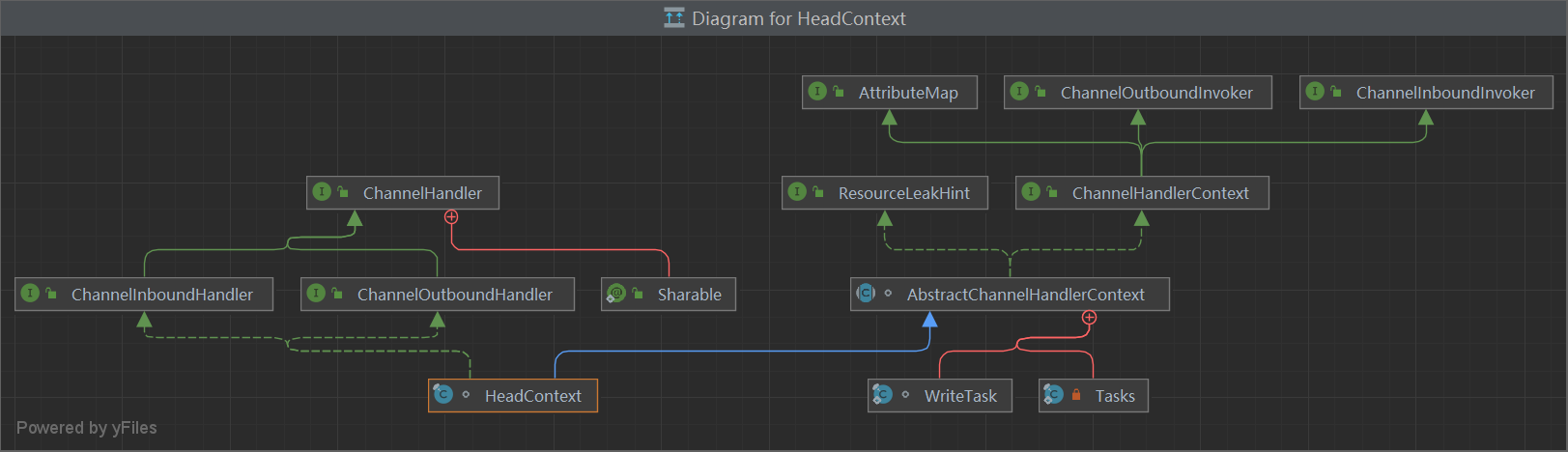

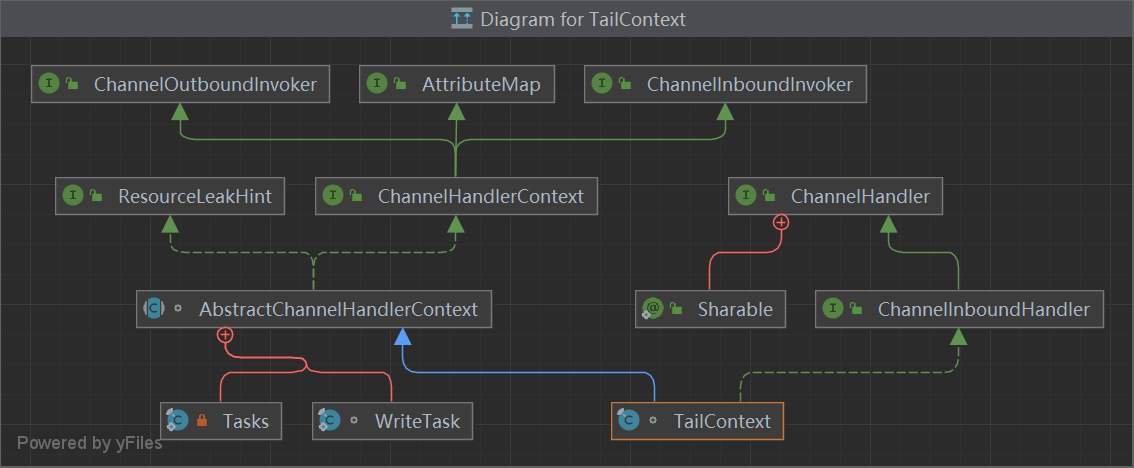

HeadContext — TailContext

Handler

处理器Handler主要分为两种:

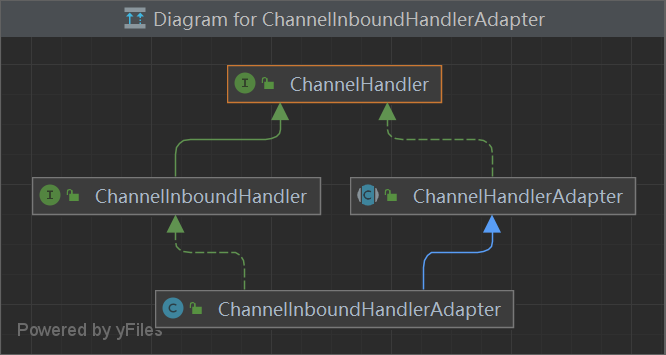

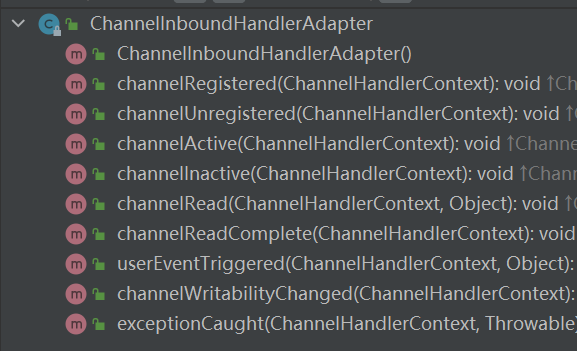

ChannelInboundHandlerAdapter(入站处理器)、ChannelOutboundHandler(出站处理器)

入站指的是数据从底层java NIO Channel到Netty的Channel。

出站指的是通过Netty的Channel来操作底层的java NIO Channel。

ChannelInboundHandlerAdapter处理器常用的事件有 :

注册事件 fireChannelRegistered。

连接建立事件 fireChannelActive。

读事件和读完成事件 fireChannelRead、fireChannelReadComplete。

异常通知事件 fireExceptionCaught。

用户自定义事件 fireUserEventTriggered。

Channel 可写状态变化事件 fireChannelWritabilityChanged。

连接关闭事件 fireChannelInactive。

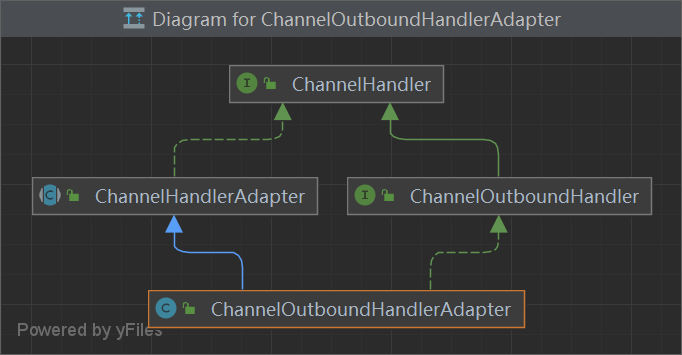

ChannelOutboundHandler处理器常用的事件有 :

端口绑定 bind。

连接服务端 connect。

写事件 write。

刷新时间 flush。

读事件 read。

主动断开连接 disconnect。

关闭 channel 事件 close。

还有一个类似的handler(),主要用于装配parent通道,也就是bossGroup线程。一般情况下,都用不上这个方法。

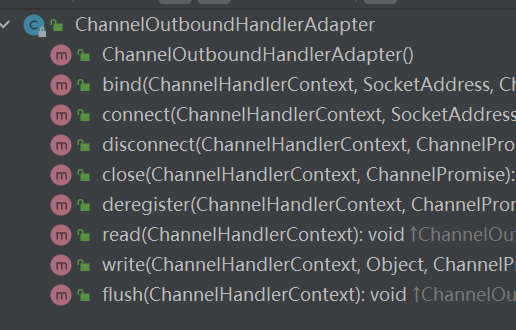

ChannelOutboundHandlerAdpater

ChannelInboundHandlerAdpater

Read() Write() 5种IO模型 大白话详解5种网络IO模型 (qq.com)

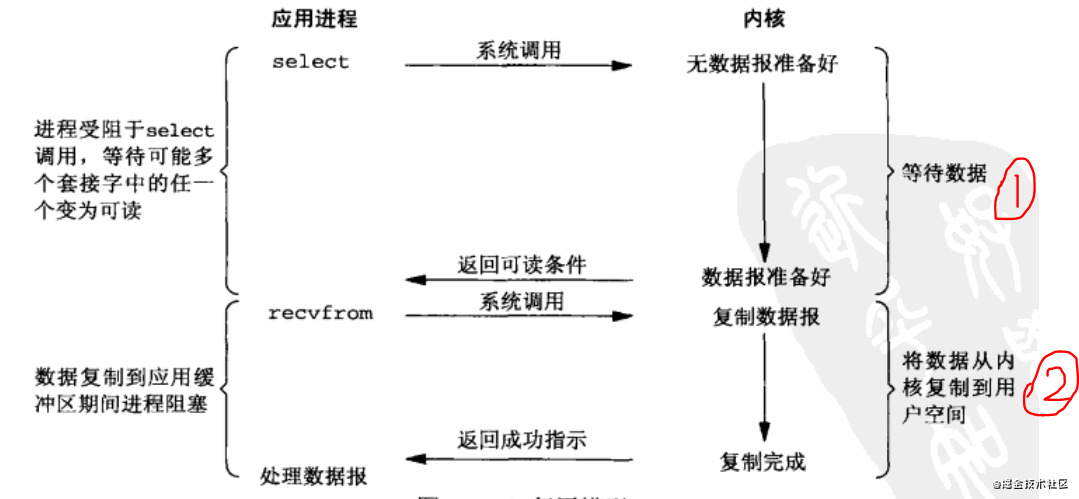

1 2 3 4 5 6 7 8 9 10 关键指令:select ()、poll (链表)、epoll (红黑树) -- op_connect, op_accept, op_read, op_write,Recvfrom

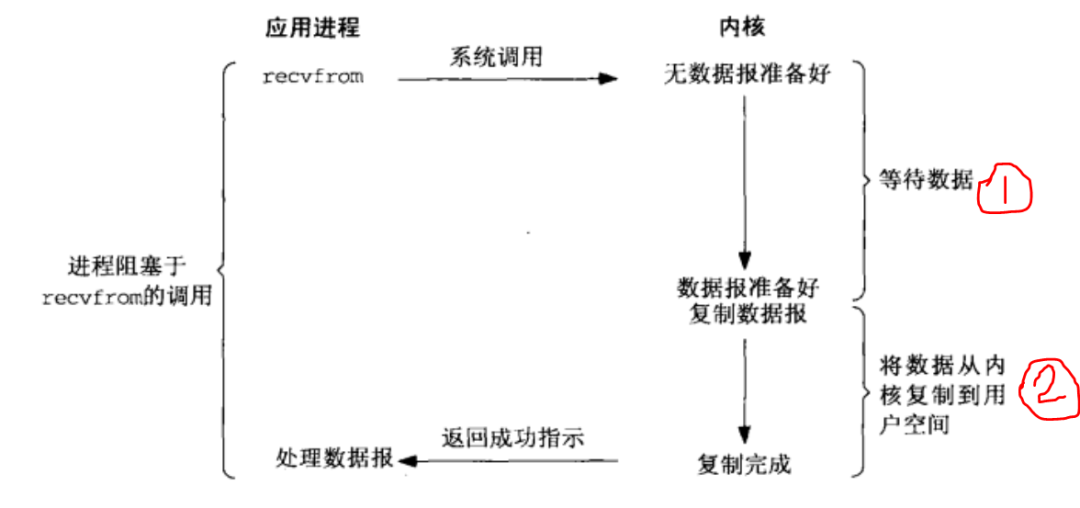

阻塞IO

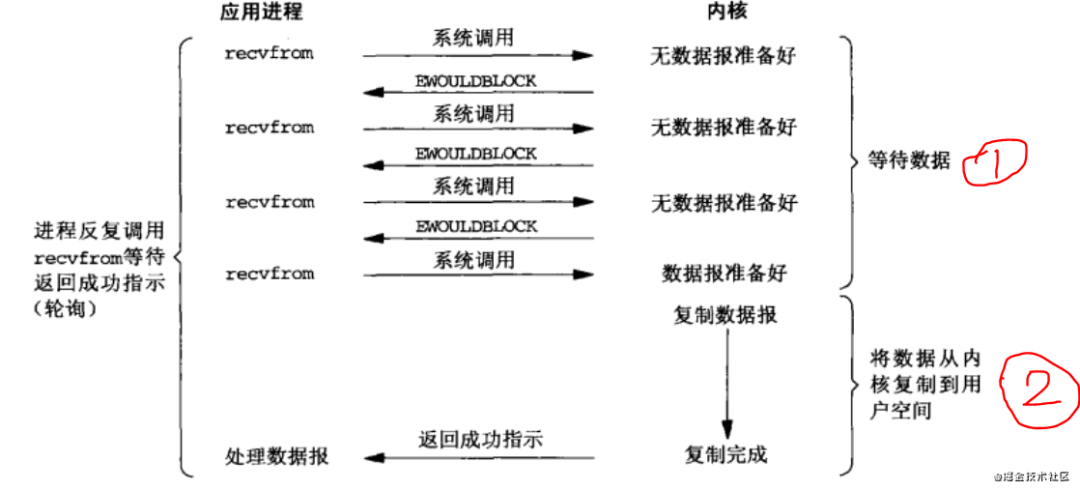

非阻塞IO

IO多路复用

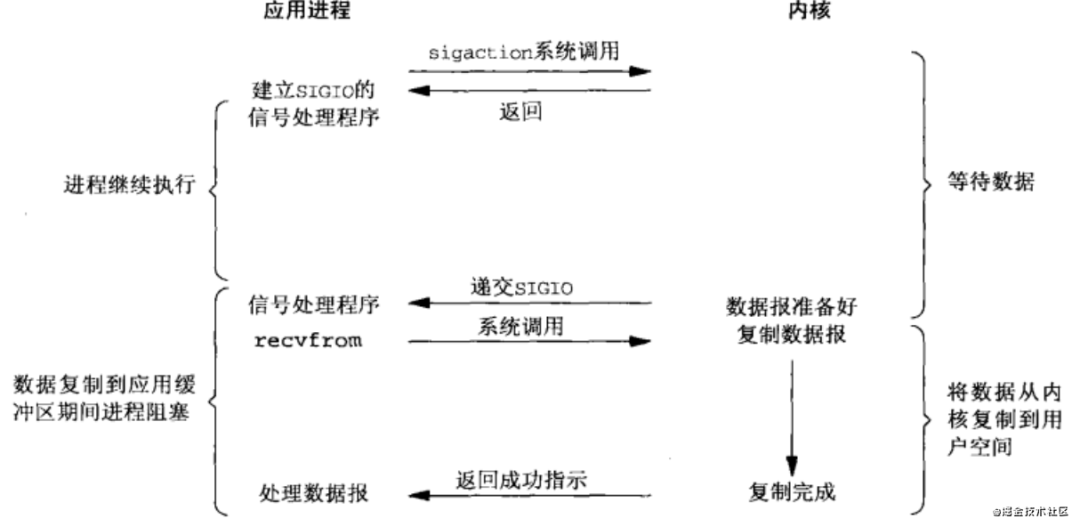

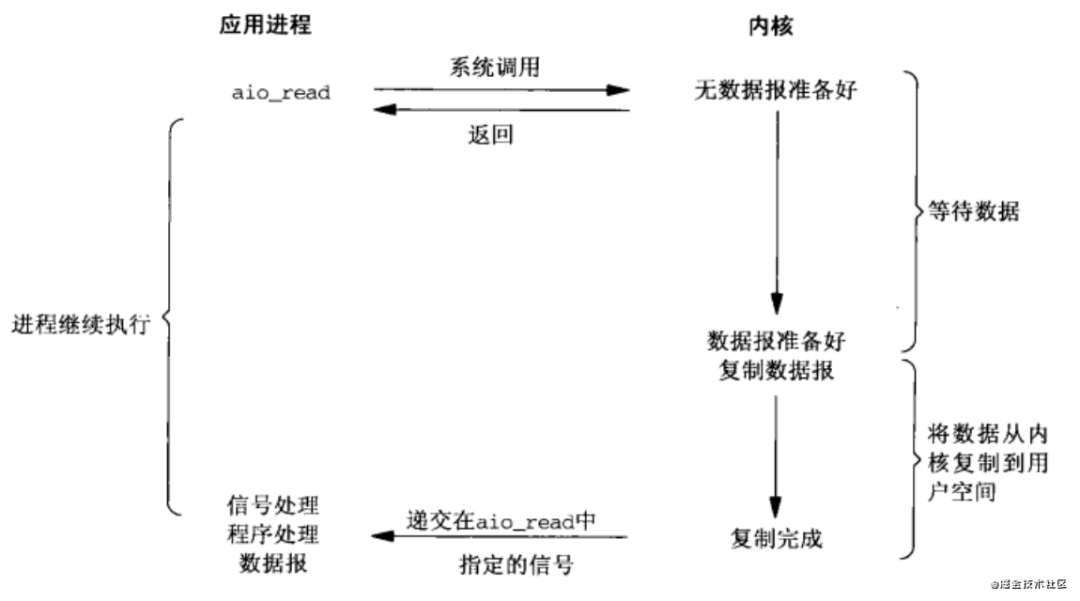

信号量机制

AIO异步非阻塞

Reactor和Proactor (5 封私信) 如何深刻理解Reactor和Proactor? - 知乎 (zhihu.com)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 NIO模型.0 ,在JDK7才开始支持。

阻塞IO:数据处理、数据拷贝都会阻塞

非阻塞IO :数据处理轮询 ,数据拷贝阻塞

异步IO:数据处理和数据拷贝 都不阻塞

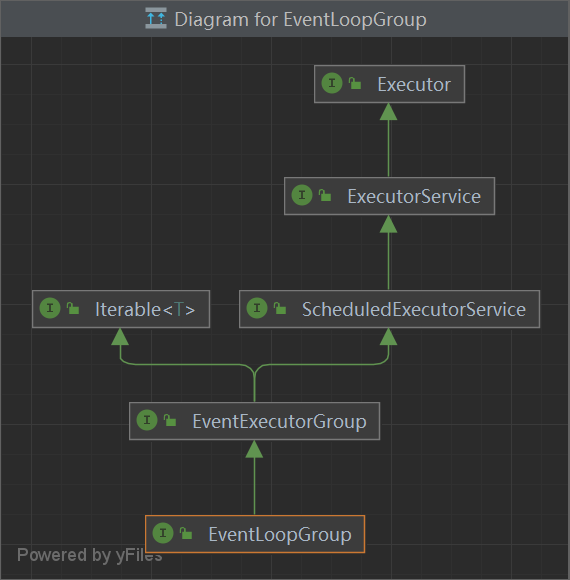

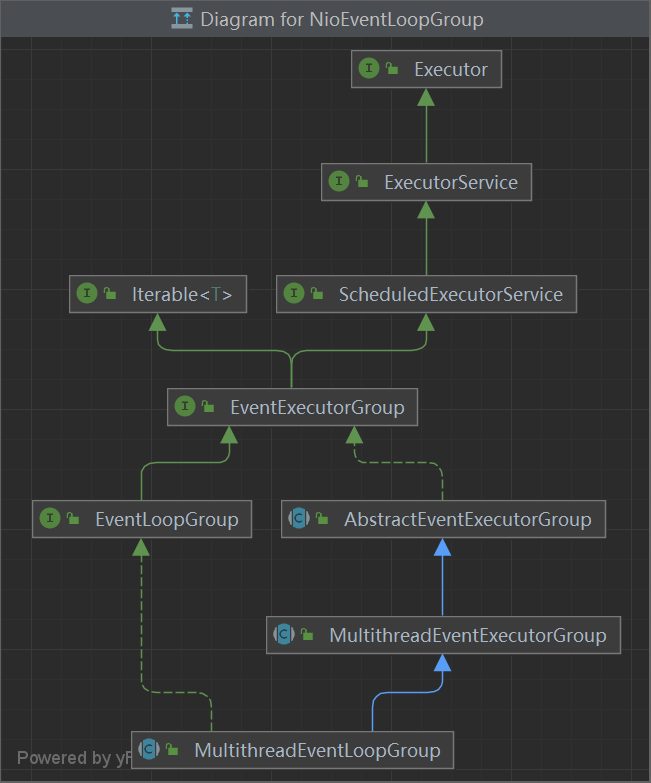

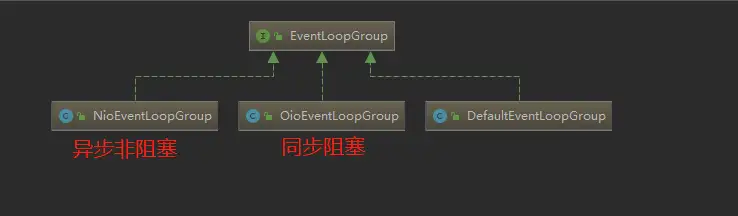

EventLoopGroup 我们先看一下EventLoopGroup的类图:

其中包括了常用的实现类NioEventLoopGroup。OioEventLoopGroup在前面的例子中也有使用过。

从Netty的架构图中,可以知道服务器是需要两个线程组进行配合工作的,而这个线程组的接口就是EventLoopGroup。

每个EventLoopGroup里包括一个或多个EventLoop,每个EventLoop中维护一个Selector实例。